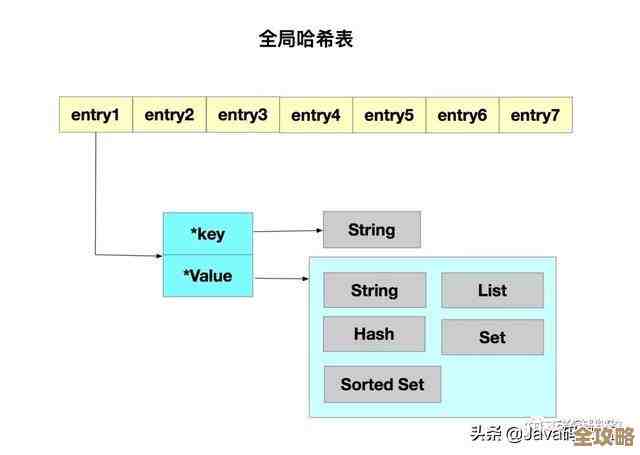

Redis里头哈希表太大了,咋整?这次有点新花样想法试试看

- 问答

- 2025-12-23 12:19:14

- 1

Redis里头哈希表太大了,咋整?这次有点新花样想法试试看

这个问题其实挺常见的,就是当Redis里存的某个Hash数据结构的字段(field)和值(value)特别多,体积变得巨大无比的时候,会带来一堆麻烦,可能导致Redis操作变慢,内存占用太高,甚至在做持久化(比如生成RDB快照文件)或者主从同步时,因为要处理这个大块头而造成服务短暂卡顿(也就是“阻塞”)。

那传统上咱们都咋处理呢?无非就是拆呗,比如把一个大的Hash拆成好几个小的Hash,用某个规则把字段分散到不同的Key里去,这个方法挺实在,但有时候感觉不够优雅,管理起来也麻烦。

最近我琢磨着,能不能换个思路,玩点新花样?不一定成熟,就当是抛砖引玉,一起探讨一下。

借用Stream数据类型的思路来“分片”

Redis不是有个Stream类型吗?它本身就是为了处理大量数据流的,内部是用多个节点(radix tree)来存储消息的,我就在想,虽然我们不能直接把Hash转成Stream,但可以借鉴它那种“分而治之”的思想。

我们可以尝试一种“动态二级索引”的方法,别被名字吓到,其实很简单,我们有一个巨大的用户信息Hash,Key是user:info,里面存了上百万个用户的详细信息,与其硬拆成user:info:shard1, user:info:shard2...,我们可以这样做:

- 主Key存索引: 我们把

user:info这个Key本身,不再当作存具体数据的地方,而是变成一个“索引目录”,它里面存的不是用户数据,而是一些指向真正数据块的指针,我们可以按用户ID的范围或者哈希值,把用户分组。 - 数据存到子Key: 每一组用户的数据,实际存放在一个独立的、更小的Hash里,Key的名字可以像是

user:info:chunk:[组标识],用户ID从1到10000的,放在user:info:chunk:1里。 - 索引的作用: 当我们要查询某个用户的信息时,先到

user:info这个“目录”里查一下,看看这个用户ID属于哪个“数据块”(chunk),然后再去对应的user:info:chunk:X里读取数据。

这样做的好处是,拆分是逻辑上的,对应用程序来说,它可能只需要跟一个“索引Key”打交道(或者由客户端封装好逻辑),而实际的数据存储是分散的,当某个数据块又变得太大时,我们可以只针对那个块进行再次拆分,比较灵活,这比一开始就定死分片规则可能更适应数据增长的变化,这个想法某种程度上受到了数据库分库分表思路的启发。

巧用ZSet的分数做“冷热分离”

另一个想法是利用有序集合(ZSet)的特性来辅助管理大Hash,这个点子来源于一种常见的场景:一个大Hash里,可能只有一部分数据是经常被访问的(热数据),大部分数据可能很久才用一次(冷数据)。

我们可以这样做:

- 建立访问评分机制: 除了那个大Hash(假设叫

big_hash)本身,我们同时维护一个与之关联的有序集合(比如叫big_hash:access_score),这个ZSet的成员(member)就是Hash里的字段名(field),而分数(score)则代表这个字段的“热度”或最近访问时间戳。 - 动态更新热度: 每次有命令访问(读或写)

big_hash里的某个field时,我们都同时用ZADD命令更新一下big_hash:access_score里对应field的分数(比如用当前时间戳作为分数)。 - 定期清理或归档冷数据: 我们可以定期(比如用Redis的定时任务Lua脚本,或者外部程序)检查这个ZSet,通过

ZRANGEBYSCORE命令,我们可以很容易地找出那些分数很低(即很久没被访问)的field,对于这些“冷”字段,我们可以选择:- 直接删除: 如果数据可以重建或不再需要,就直接从

big_hash中删除,同时也从ZSet中移除。 - 归档到其他存储: 如果数据还有用但访问频率极低,可以把它们从

big_hash中移出,转存到更节省成本的存储中(比如另一个专门存冷数据的Redis实例,甚至磁盘文件),并在big_hash里只留一个指向归档位置的指针,这样,主Hash的体积就得到了控制。

- 直接删除: 如果数据可以重建或不再需要,就直接从

这个方法的核心思想不是简单地拆分数据,而是根据数据的访问模式来优化存储,把资源留给热数据,这需要一些额外的开销来维护ZSet,但如果访问模式是偏重少数热点的话,收益可能会很明显。

结合Lua脚本实现“自动化小规模拆分”

第三个想法是尝试利用Redis的Lua脚本来实现更智能、更自动化的管理,Lua脚本可以在服务器端原子性地执行一系列操作。

我们可以设计一个脚本,它在执行写入操作(比如HSET)时,会先检查目标Hash的大小(可以用HLEN命令判断字段数量),如果发现字段数量超过了我们预设的一个阈值(比如5000个),脚本就自动触发一个“拆分动作”。

这个拆分动作可以是这样的:

- 创建一个新的、空的Hash Key(比如原Key名加上一个递增的后缀或时间戳)。

- 将原Hash中一部分字段(比如一半)迁移到新的Hash中,迁移过程可以在Lua脚本中通过循环和

HMGET/HMSET模拟,但要注意Lua脚本的执行时间不能太长,以免阻塞服务器,对于超大的Hash,可能需要在客户端配合下分步进行,但脚本可以完成决策和初始化。 - 更新一个元数据信息(比如一个专门的Key),记录下这个原始Hash已经被拆分,以及拆分后的子Hash列表。

这样,拆分的过程对客户端可以是近乎透明的(尤其是读操作,可能需要客户端知道如何去所有子Hash里查找,或者由一个代理层来处理),这种方法的“新意”在于将管理的逻辑下沉到Redis服务器端,实现一定程度的自治,减少客户端的复杂性,这对脚本的健壮性要求很高,要小心处理边界情况。

总结一下

这些“新花样”——无论是借鉴Stream的动态二级索引、利用ZSet的冷热分离,还是通过Lua脚本实现自动化拆分——核心思路都是从“被动拆分”转向“更智能、更动态的管理”,它们不再是把一个大Hash静态地、一刀切地分成几块,而是试图根据数据的内在特性(如关联性、访问频率)或者通过设定动态规则来优化存储结构。

这些想法都各有优缺点,需要在实际场景中仔细评估,维护索引或热度ZSet会有额外开销;Lua脚本的复杂逻辑可能引入bug和性能风险,最根本的解决方案可能还是在于业务层面,比如审视数据设计的合理性,是否所有数据都需要存在Redis里,有没有可能优化字段结构等。

但无论如何,面对Redis大Hash这种“幸福的烦恼”,多一些天马行空的思路,总比永远守着一种方法要好,说不定哪个点子经过改造,就能在你的特定场景下发挥奇效呢。

本文由盈壮于2025-12-23发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://www.haoid.cn/wenda/66906.html